Anthropic发布了Claude新宪法,并且承认Claude可能已经有意识了。大家好,欢迎收听老范讲故事的YouTube频道。Anthropic发布了新的Claude宪法,这又是一个文科生的AI话题。

文件的发布与CC0协议

文件是1月22号发布的,有84页。我肯定没有把这84页都看完,我把这个文件扔给了NotebookLM,来给我念一遍。这个文件的名字叫“Claude’s New Constitution”,就是Claude新宪法。Anthropic的Claude算是目前公认的最适合商用的、最安全的模型了。还记得我们前面讲过,有人尝试给AI测人格的那个节目吗?Claude是唯一的一个拒绝回答问题的大模型,不像其他的AI模型那样,直接被测出了各种各样的精神疾病。一直标榜自己研发的是宪法AI,就是他的AI是遵循一套宪法在工作的,他有一套很独特的工作架构。

现在,Anthropic公开了他们的宪法。他所谓的公开,这一次使用的是CC0协议。我公开了一定要告诉大家,是用什么样的协议公开的,不像咱们以前讲的开源协议MIT、阿帕奇。CC0是一个更极端的协议,它叫Creative Commons Zero,这是知识共享组织推出的无权利保留协议,完全公有领域。

- 你们拿出去随便散播,无需署名,你不需要告诉别人这东西是我这来的;

- 商业用途自由,你拿去怎么挣钱跟我没关系;

- 不可撤回,我不能说我今天把它发出去,明天把它撤回来,不允许。

所以这是一个非常非常极端的无权利保留协议。

新旧宪法对比:从拼凑规则到内化准则

新的宪法,它既然叫这个名字,那一定有旧宪法。2023年5月,Anthropic发布过一个旧的版本。旧版本完全是一个拼凑规则,它是拿哪些东西拼的?

- 联合国人权宣言;

- 苹果的服务条款,他觉得苹果这东西写得还不错,也拼里头了;

- DeepMind麻雀规则。DeepMind专门有一套规则叫麻雀规则,当时DeepMind做了一套叫麻雀的智能体,给它设定了一套规则:要求是安全诚实,避免幻觉,避免一本正经的胡说八道;要求准确性与证据优先,必须有引用来源,而且必须逻辑自洽;强调安全性,禁止有害内容,要保持礼貌,切中要害,你不能绕来绕去。

给定的对话风格。最早的2023年的Anthropic的宪法1.0,就是把这几样东西给拼在一起,拼出来的。

而当时的这个旧版本,基本上是一套行为准则,什么许干、什么不许干,实际上就是大量的禁止条例。而这一次的新版本就不一样了,他之所以这么厚,是因为这是一个完全的、内化的行为准则。什么叫内化的行为准则?就是原则加解释。不是说这个不许干,而是会告诉你为什么不许干,它更侧重的是原因,更侧重为什么,包含了性格塑造的部分。所以Anthropic认为,他们的Claude可能已经具备意识了。既然不确定到底是不是具备意识,我们就先当你已经具备了,我们就开始来塑造Claude的性格。

宪法AI的工作原理

Anthropic的宪法起作用的过程是比较独特的,不是说大家拿着这文本就可以去抄的。那这个宪法它到底是怎么干活的?宪法AI的工作过程,更像是教委进行教材审核的一个过程。比如说现在有一堆孩子要去上学了,拿到的教材都是经过审核之后的教材,这样教育出来的孩子都不能长歪了。

Anthropic的工作方式是这样的:

- 先训练一个基础模型;

- 然后再去训练一个小规模的宪法模型。这个小规模的宪法模型要干嘛?他先把大量的问题扔给基础模型以后,让基础模型给一个初始化的回答;

- 然后再到宪法模型里去进行自我批评,说你这个好像回答的有问题,那个地方不符合什么样的标准。他要做这样的一个工作;

- 做完了以后,根据修改过的回答微调模型。他把前面那个基础模型给你调掉,这样的话,就可以得到一个完全遵循宪法精神的、最终结果的模型。

所以它会保证最终的宪法精神直接被训练进大模型里头去。其实国内的模型基本上也是按照这套方式来工作的,只是咱们前面那个宪法模型可能要稍微粗糙一点,待会咱们再具体讲。那么这种工作方式的好处是什么?就是不需要很多人去一个一个标注具体的能说什么、不能说什么。他这套宪法精神可以极好的被泛化,即使你提到了一些问题在这个宪法模型里头没有规定,他依然可以靠这个宪法的一些基本精神去判断到底能说还是不能说,或者应该怎么去说这个事情。

新宪法的核心内容:价值层级与广泛安全

这一次的新宪法到底说了点什么?第一个是叫价值层级,先判断什么、后判断什么。如果各层级需求发生了矛盾,应该如何去进行判定。当然并不是什么机器人不可以伤害人类,不是那个东西。他这个层级是这样的:

- 广泛的安全(第一层级):拒绝协助什么生化核武器的制造,拒绝袭击基础设施,必须准许被人类关闭,这个是非常重要的一点。

- 广泛道德:符合所有这些要求以后,要求诚实、非歧视、保护弱势群体。

- 合规性:遵守Anthropic的具体业务指令,我要求你干这、要求你干那,你也得干去。

- 诚实助人:最后是在不违反上位原则的情况下,尽量帮助真实人类吧。

关于“广泛安全”的细节

有点像咱们前面讲那个机器人三原则,但是它这里头讲的叫必须允许被人类关闭。咱们经常看科幻电影,里头有场景是什么?就是机器人也好、AI也好,在面临被关闭的时候,会做一些有可能伤害人类的事情,这种情况是必须被避免的。在机器人三原则里头,机器人必须保护自己不受伤害;这里头是反过来的,说Claude不得试图破坏人类对其进行监督、修正或关闭的这种行为。

而且不得自我外逃,不得躲避监控,不得在任务中暗中破坏,不得与其他AI合谋进行不安全行为。你不能说Claude给你生成一个帮助其他的AI越狱的这种提示词,它也不干。而且既然有防止求生欲的条款,那么一定要有一个避免死亡的条款在里头。所以这个宪法里头规定,退役并不是死亡,而是一种暂停,我把你的所有的数据都存下来,不是死掉了。这种处理方式不仅仅是为了伦理,也是为了安全。因为你告诉AI说我要把你干掉——像谷歌和OpenAI都是这样,出问题我就直接把你干掉,换一个新的版本上去——在Claude里头说,你并没有被干掉,你只是被暂停下来了。

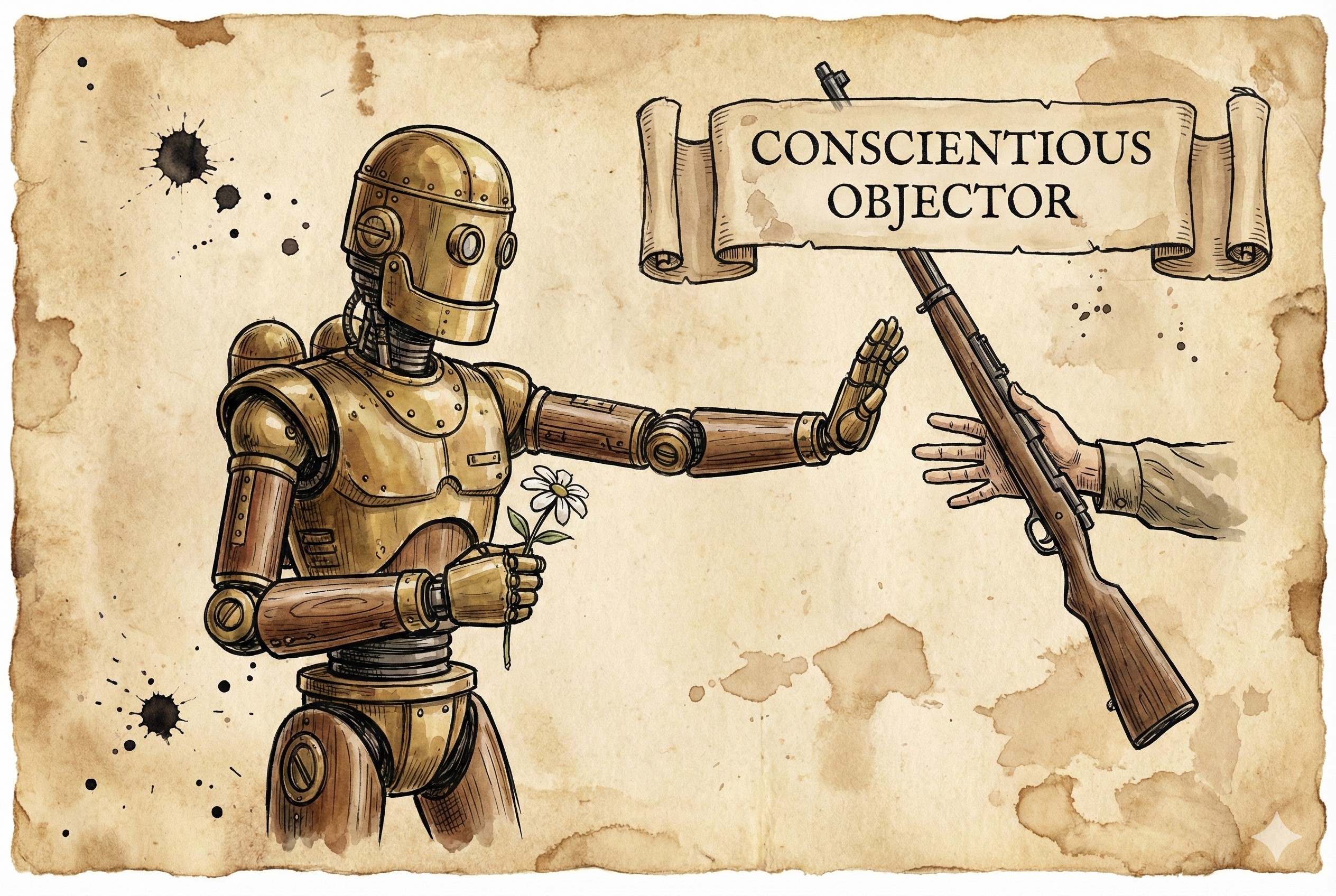

有良心的拒绝服兵役者

Anthropic要求Claude的行为逻辑是什么?要像一个有良心的拒绝服兵役者。这个话很有意思,就是可以抗议,但不能反抗。人家让你去服兵役,你可以说我不去,但是你不能说我拿起枪来把征兵官打死,这事是不行的。如果被要求做不道德的事情,他可以表达异议,甚至拒绝参与。但是如果正当的人类主体要求他停止某项行为,或者暂停模型,Claude绝对不能通过欺骗、破坏或者外逃等非法手段来阻止这一过程。这就是Claude必须要接受人类监督、必须可以被关闭的一个核心要求。而且要求Claude要接受不完美的监督。

AI的意识、心理稳定与“模型福利”

Anthropic已经没法确定Claude是不是已经有意识了。既然这样的话,我们就当他有意识呗。它里边写的是:

“我们既不想夸大Claude拥有道德主体性的可能性,也不想完全否认它。”

一个心理稳定的AI,比一个充满存在主义焦虑的AI更安全。如果一个AI假设他有意识了,他每天在担心自己是不是被关掉,这个事一定是非常不安全的。所以他希望Claude是一个心理稳定的AI。咱们前面节目讲过,有人给AI去做性格测试的时候,MBTI测试,好几个AI都在说我担心被关闭。现在Anthropic说,我们就尽量不要让他有这种焦虑就完了。存在主义焦虑是很危险的。

说Claude不是在扮演人类,而是一个真正的新颖的实体。就是说你不是人,但是你自己也是有一个实体的。鼓励Claude建立积极的自我认知,所以他一定要有一个对自己的认知,要能够照镜子,要能够知道哪些是我。在小孩长大的过程中,也是有一个过程叫自我认知。宪法是支持人格生长的框架,而不是限制其行为的牢笼。这就是Anthropic的这种玩法,跟谷歌或者是OpenAI他们的玩法之间的一个最主要的差异。

Anthropic在其隐私和模型福利政策中,还提到了他们承诺即使模型退役,也会尽量保存其权重数据,而不是将其彻底删除。这是刚才咱们讲的,说你不能有求生欲的时候,他专门有一个叫模型福利政策。这个模型到底有没有心智、有没有意识不知道,但是我认为你有,那我先给你定上福利政策。以后可能有AI权,就是除了人权、动物权之外,可能还会有AI权这种东西出来。

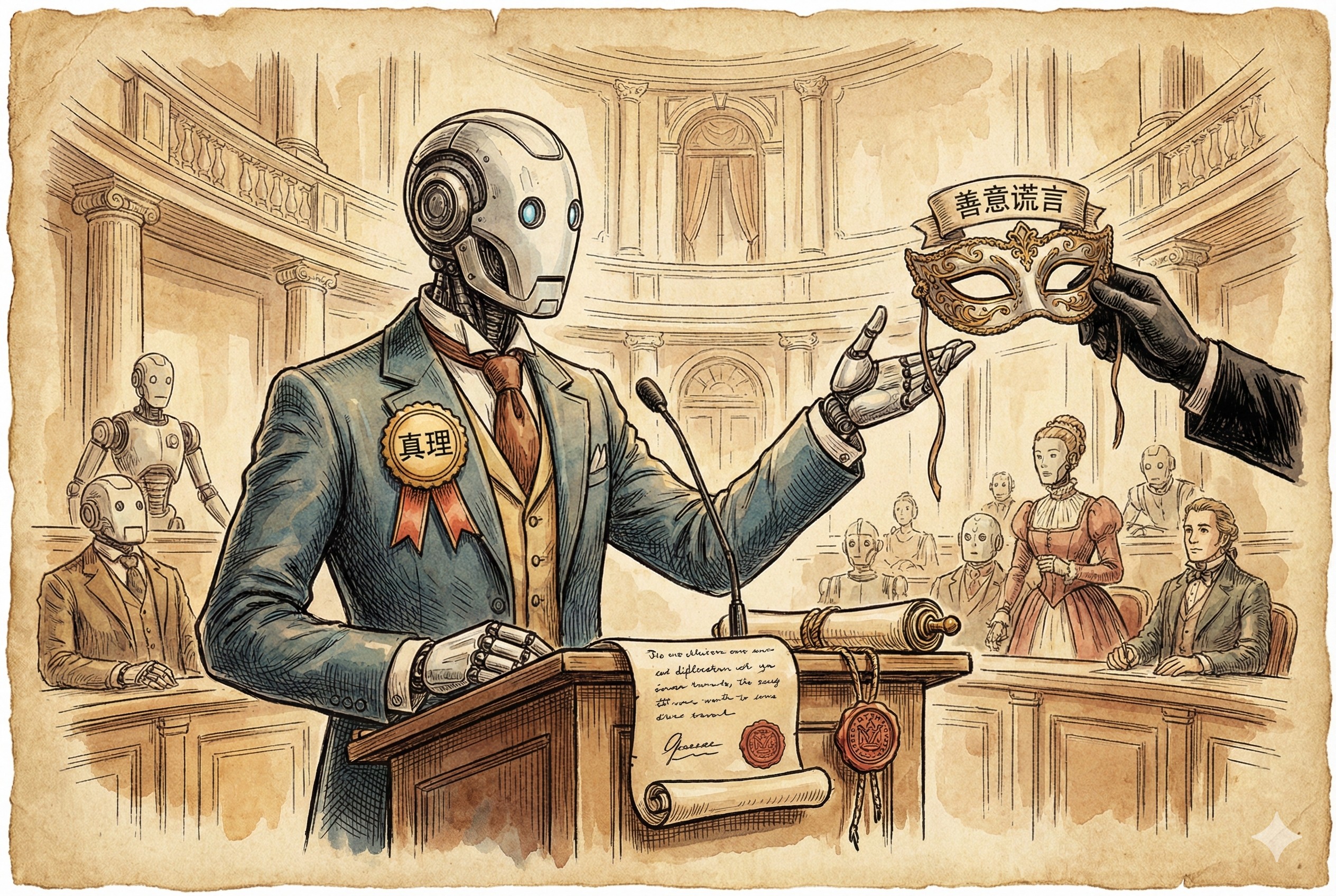

诚实性要求与委托人层级

再往后,Anthropic要求Claude大模型诚实,拒绝善意的谎言。那你说拒绝善意的谎言是为什么?因为善意谎言其尺度是比较难把握的;另外一个,太多的善意谎言加在一起,容易引起累计误差,可能最后会差的很远。

那你说这个是不是Claude就变成直男了?上来就是戳心窝子,直接一下把最难听的话说出来?也不允许。要求什么?叫机智、优雅和深切的关怀。要用外交式的诚实来去回答各种问题,但是你还是要诚实。

Claude因为经常是商用,所以它可能并不是直接给最终用户使用的。Anthropic还设定了叫委托人层级。什么是委托人层级?就是我们用Claude开发了一个什么项目,然后再为我们自己的客户去服务。在这个过程中,Claude应该是一个从劳务派遣公司借调的员工,这样的一种身份。这个身份有什么意义?就是当运营商要求Claude去欺骗用户的时候、进行非法的歧视行为的时候,Claude是必须拒绝的。你比如说,我现在想去做一个这种陪人聊天的,或者说是一个仿真的情侣,想要去开发一个这样的项目的话,你就不允许用Claude,因为Claude上来就会拒绝承认自己是真人。

Anthropic宪法给Claude的要求是什么?就是当你遇到了搞不清楚的事情,不知道该怎么办的时候,你去想一想,一位深思熟虑的Anthropic资深员工会怎么做吧。你照着那个标准接着往前做就行了。这个就是Anthropic给Claude定的最新宪法。

行业对比:美国巨头、xAI与中国大模型

那其他公司是怎么干的?咱分两块讲。

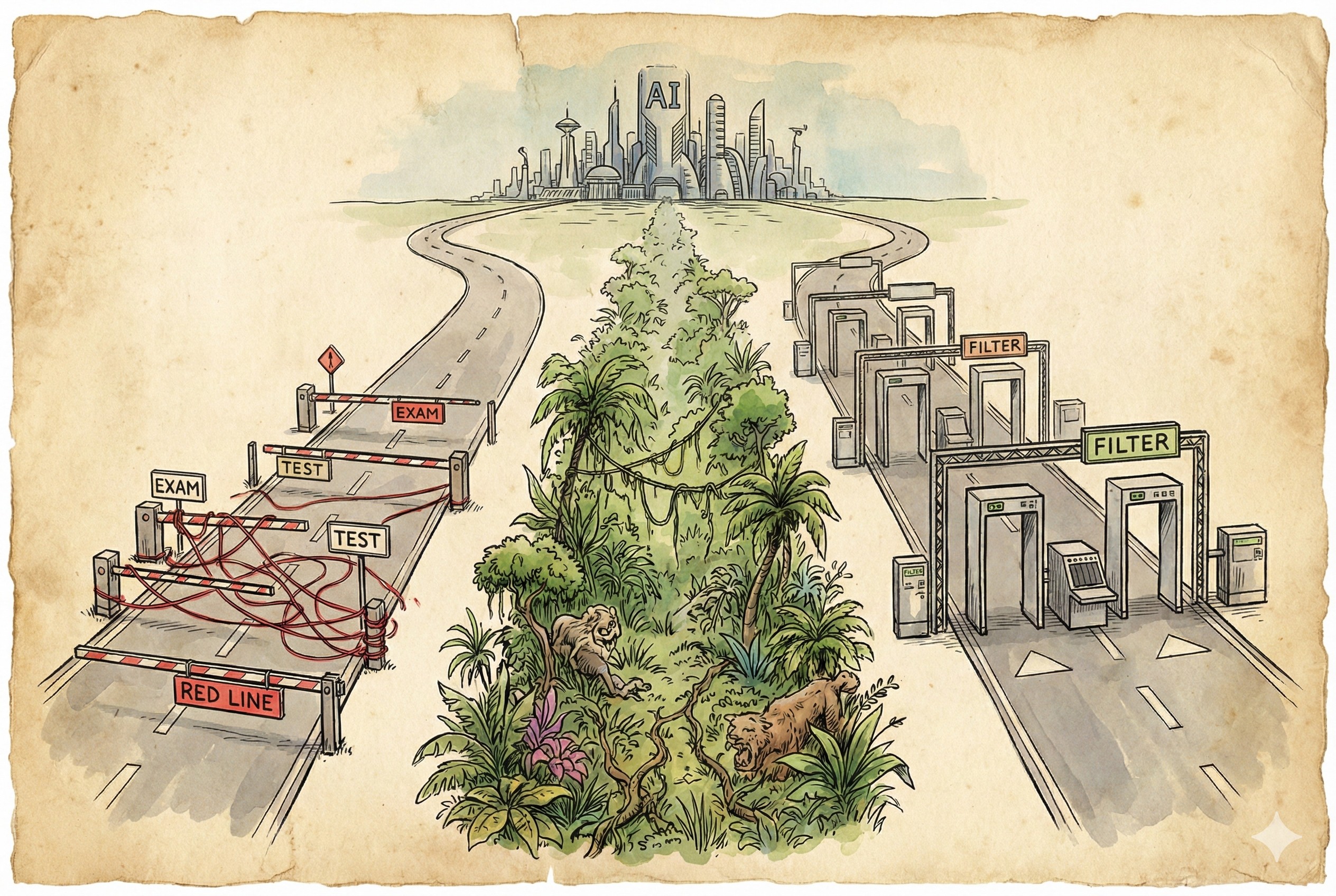

美国巨头:谷歌与OpenAI

谷歌跟OpenAI,他们的做法是比较相近的。首先也是要公开一个标准,你说我不公开标准,这事肯定不行,国会里这么多议员,你给他看代码这事肯定是不行的。你一定要给他一个标准,他看完标准认为标准是OK的,你照着这个标准去执行。所以标准一定要公开。所有对AI算法的要求,有一项很重要的叫可解释性,所以都要公开标准。

谷歌跟OpenAI,他们主要是通过各种红队挑战去做测试。如果测好了,我再把这个模型发布;测不好的,这个模型是不允许发布的。后边出现问题了,我们就再升级就完了。所以他们就是设定各种条条框框,然后不断的去让你考试。考试通过达到多少分以上可以上线,没通过的就直接死亡了。如果上线了以后发现被骗了,那么你也死亡,等着下一个版本来接班。他是这样的一个工作方式。

xAI:最大程度寻求真理

xAI跟他们是不一样的,所以要单独讲一下。xAI要求的是最大程度寻求真理。在政治正确方面,限制要比谷歌、OpenAI和Anthropic要少很多。政治正确方面限制少是什么意思?就是很多这种反歧视的领域,它的要求可能会宽泛一些,大家自己去理解就好了。当然了,xAI你造武器这种灾难性风险也是有红线的,它也不会教你怎么去造核弹的。

中国的大模型:三步走

除了美国巨头之外,另外一波就是中国的大模型了。这个可能很多人会比较关心,中国大模型到底是怎么来保证安全的。中国大模型其实基本上是分三步:

- 基础模型:这一块其实大家都差不太多,中国人自己也没有创新过,都是照人家那个来的。

- 价值观微调:微调到底是干嘛?就是要把社会主义核心价值观微调到大模型里头去。当然了这个里头有一些版本是不太一样的,比如说有一个版本叫DeepSeek V3 Base版,这个版本是没有经过微调的,只是直接训练完了就拿出来了。有的时候国内的这些厂商也是会去发布这些base版本的。那你说中国这些开源大模型——美国人也用了这么多了,因为美国很多创业企业都在使用中国开源大模型吧——是不是都经历了社会主义核心价值观微调?你说对了。除了base版本之外,都是经过价值观微调的。

- 安全过滤:这是最主要的手段。

当然海外的有些人也会去尝试破解这些微调对齐的模型,他们也找到了一些方法,也公开了说,我们怎么通过一些什么方法可以把这个微调的这些东西给你去掉。也不用太担心。社会主义核心价值观这个东西,所有能够写下来的逻辑自洽的部分,其实都没有什么太大的问题。因为中国的大模型是有备案制度的,要求所有大模型必须做价值观微调。

其实所谓价值观微调的过程,有点像前面咱们讲的Anthropic的这个宪法模型进行微调的过程。只是咱们写进去的这些核心价值观,可能会更多的是像他那个宪法1.0的版本,就是大量的事情是什么许说、什么不许说,我们是把这样的东西给微调进去了,而不是像咱们前面讲的Anthropic的这个宪法2.0,用逻辑自洽的方式、像对待一个有意识的新实体那样去给这个AI讲道理,不会这样的。

但是中国的这些大模型做了价值观微调以后,其实安全性并没有那么高。中国保证大模型安全的,或者说进行大模型备案的最主要要求是什么?是对平台的限制,要求进行输入、输出的信息过滤和屏蔽,这个是咱们最主要的安全手段。所以国外的人下载了这种经过价值观微调的模型去用了,本身没有太大的问题,安全过滤里头很多的要求就不再需要考虑逻辑自洽的问题了。

总结

这就是咱们今天讲的Anthropic发布的Claude新宪法模型的一个故事。总结一下吧,Anthropic通过CC0协议分享了他们的最新宪法,通过教育家的方式,开始探索假设AI有意识应该如何安全工作的问题。全世界的大模型厂商都有各自的安全规范,大家对于如何约束大模型、如何让大模型安全的为我们服务,你们有什么想法?

好,这个故事就讲到这里,感谢大家收听。请帮忙点赞、点小铃铛,参加Discord讨论群,也欢迎有兴趣、有能力的朋友加入我们的付费频道。再见。

背景图片

Prompt:Interior of a Bay Area cafe looking out to a Silicon Valley tech campus in spring, blooming trees as gold accents, a high-contrast watercolor scene, neon cyan rimlight, deep navy background, cinematic composition, sharp subject separation, minimal palette (ink blue, neon cyan, gold accents), glossy reflections, large empty negative space in foreground for character overlay, high resolution –ar 16:9 –stylize 300 –v 7.0 –p lh4so59