12 月 10

Luke FanAIGC, Google的故事 5到10年, AGI, AGI 时间表, AI Agent, AI突破, AI路线图, AI进展, AI预测, AlphaFold, AlphaGo, Axios AI峰会, Demis Hassabis, Gemini, Gemini 3, Google Deepmind, 世界模型, 人类水平AI, 大模型局限, 强化学习, 德米斯·哈萨比斯, 技术挑战, 持续学习, 智能体系统, 蛋白质折叠, 认知神经科学, 诺贝尔奖得主, 谷歌AI, 谷歌大脑, 通用人工智能, 长期规划

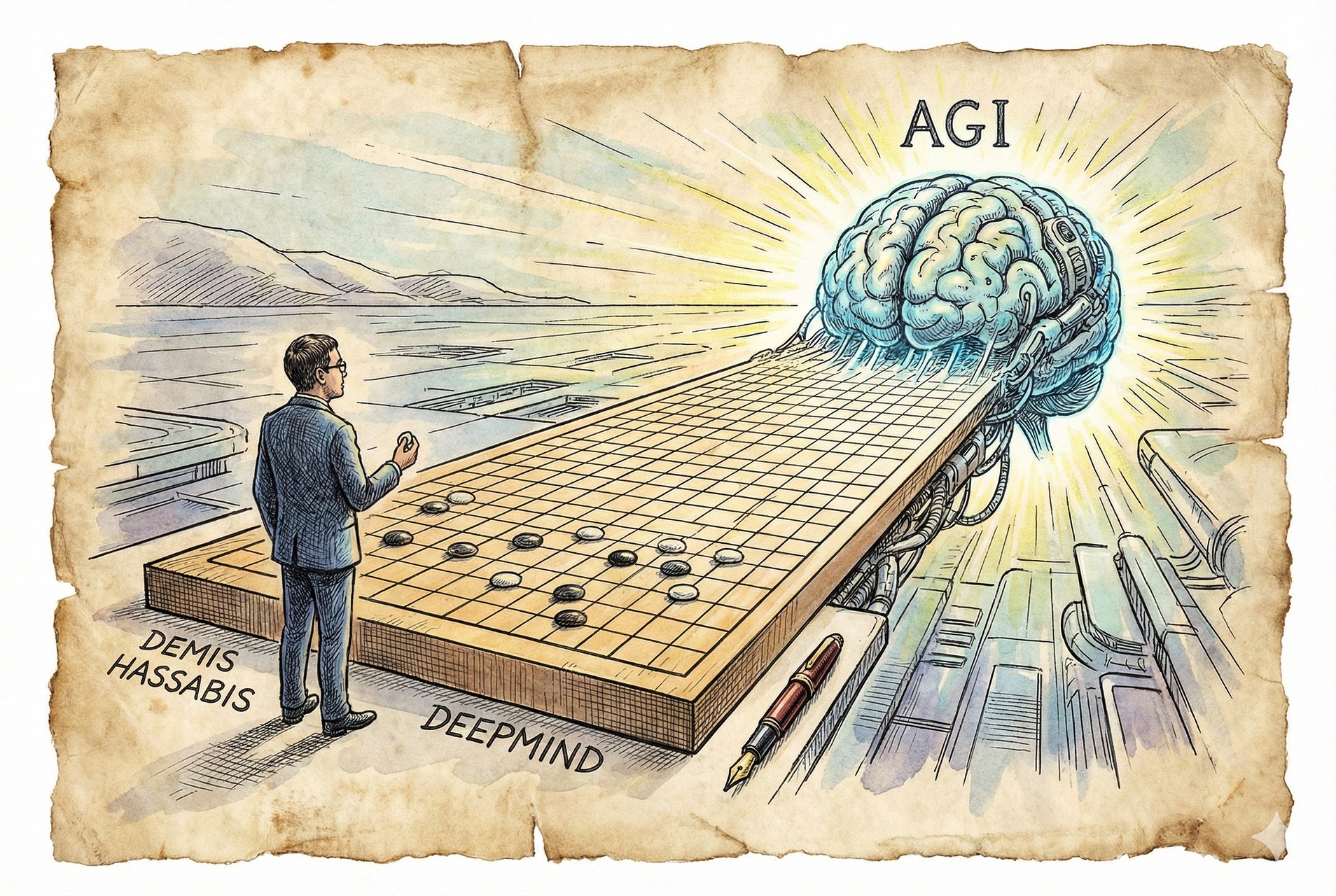

谷歌Deepmind的CEO说:“我们与AGI之间,只差一到两个AlphaGo级别的技术难关了。”

大家好,欢迎收听老范讲故事的YouTube频道。

现在Gemini 3正在大杀四方,谷歌里面负责开发Gemini的部门叫Deepmind,他的CEO出来接受访谈,关注度还是比较高的。

谷歌Deepmind的首席执行官叫德米斯·哈萨比斯,2025年12月4日接受了一个访谈,是在旧金山举行的Axios AI大会。和他对谈的人呢,是Axios的创始人和主编,叫Mike Allen。在这上面他讲到说,我们距离AGI还差一到两个类似于AlphaGo这样级别的突破,突破过去就可以了。

哈萨比斯:爽文男主般的开挂人生

哈萨比斯到底是一个什么样的人呢?绝对的爽文男主,挂b一样的存在。

从国际象棋神童到认知神经科学博士

哈萨比斯是一个英国人,Deepmind本身是一个英国公司,后来被谷歌收购的。他呢,76年在伦敦出生,这个姓氏是个希腊姓氏。他的父亲呢,是来自塞浦路斯的希腊裔,而他的母亲呢,是来自于新加坡的华裔。所以哈萨比斯呢,可以算是半个华人。

从小,这哥们是一个国际象棋神童。像这样的人,肯定都是有异于常人之处。4岁就开始下棋,13岁就达到了国际象棋大师水准。8岁就用自己的国际象棋奖金,给自己买了台电脑,开始学习编程了。

本科和硕士呢都是剑桥的,学的CS就是计算机科学,在校期间一直代表剑桥参加各种国际象棋比赛。博士呢是伦敦大学学院,专业方向是认知神经科学和神经科学。

More

7 月 15

Luke FanAIGC, Musk传奇 20万H100显卡, 256K上下文, AI大模型, AI安全中心, AI融资, AI进程改变, API调用, Claude, DeepSeek, Elon Musk, Gemini, Grok Heavy, Grok2, GROK3, GROK4, LLaMA, OpenAI, Oracle云, Scale AI, XAI, 三体小说, 中美AI差距, 人类终极测试, 企业私有部署, 众包题库, 动态任务池, 华为盘古, 南京大屠杀, 南非白人种族屠杀, 多智能体合作, 多模态AI, 川建国, 工具支持, 市场占有率, 开源承诺, 强化学习, 意识形态投毒, 技术爆炸, 推理能力, 日本烟花事件, 昇腾芯片, 模型蒸馏, 模型迭代, 理工男模型, 电力消耗, 科研提速, 算力竞争, 编程工具, 视频生成, 越狱提示词, 过拟合预防, 预训练模型, 马斯克发布会, 黄仁勋访华, 黄色小说生成, 黑暗森林法则, 黑色幽默

史上最聪明的AI大模型GROK4诞生了。马斯克亲自坐镇开发布会。视频发布会呢,并不是特别的顺畅。第一个呢,是他晚了一个小时,也没说为什么。反正马斯克的直播经常会晚。然后呢,太多的东西需要集中发布,上下衔接的呢比较仓促一点。

最早期很多的互联网公司开发布会也是这样的,两三个小时七差咔嚓发一大堆东西。后来OpenAI这些公司习惯了在网上开直播以后呢,就慢慢把这风格改了。改成什么呢?就是每次发一个功能,发个十分钟二十分钟就完事了。然后呢,不停的发,每个月发每个月发。Xai呢,现在还没有彻底学会这件事情,还是一股脑给大家扔了一大堆东西出来。

我们以前在面对创业者的时候,每次都会苦口婆心的去做一种劝告。大家可能不知道会劝什么。作为投资人来说,我们每次看到任何一个创业者,都会上去劝一件事,叫不要憋大招。你一次要惦记着做一个大的东西,就很容易失败。你应该是做一些小的东西,一点一点放出来。OXAI现在还是憋了一个大招。当然了,XAI后面呢,也会每个月发布一个新的工具出来,它也慢慢的向这样的一个方向去前进。

More

4 月 18

Luke FanAIGC AI发展趋势, AI局限性, AI幻觉, AI应用, AI易用性, AI普及, AI未来, AI模型发布, AI编程, AI视觉, AI记忆 (Memory), AI评测, API, API代理 (Open Router), API定价, ChatGPT Plus, Function Calling, Github Copilot, GPT-4o, GPT-5展望, Greg Brockman, IDE集成, Mark Chen, Meta data分析, O3, O4 mini, OpenAI, OpenAI发布会, Sam Altman, Scaling law, Sora, TikTok直播带货话题生成, YouTube话题推荐, 一站式AI服务 (Total Solution), 世界模型, 人工智能, 内容创作, 图片推理 (Image Reasoning), 大语言模型, 实时交互, 实用AI, 工具调用 (Tool Calling), 强化学习, 推理模型, 搜索集成, 模型对比 (OpenAI vs 竞品), 潭柘寺图片识别, 科技评论, 跨模态AI

GPT-3和O4 mini发布了,这次绝不再仅仅是科学家们的玩具了。大家好,欢迎收听老范讲故事的YouTube频道。

本来GPT-3和O4 mini发布呢,我并没有抱太大的期望。为什么呢?因为前面O1和O3 mini发布的时候呢,看得我头晕眼花的。我记得应该是在去年12天连续发布会的时候发布的O3 mini,实在是太不明觉厉了。各种的复杂科学问题,咔咔就给解决了,然后各种的排名都排得很高。但是呢,我自己其实并不怎么用。

为什么呢?第一个,ChatGPT Plus用户里边呢,它是有用量限制的,并不是随便让你用的。所以在有用量限制的情况下,你就得省着用,而且你也感觉不出有太大差异来。你说你用它干嘛?据说编程很强,但是它没法跟IDE结合,基本上也就放弃了。你是可以出一大堆的代码,但是你还得向IDE里边去考来考去的,很麻烦。那你说我通过API调用吧,直接使用O1和O3 mini这些模型,实在是贵,所以就放弃了。

More

RSS

RSS