12 月 05

Luke FanAIGC, DeepSeek大模型 AI Agent, AI应用成本, AI模型评测, API降价, DeepSeek V3.2, DeepSeek V3.2 Special, DeepSeek V3.2技术解析, DeepSeek稀疏注意力, DSA算法, Gemini 3 Pro, GPT-5.1, SGLANG, VLLM, 国产大模型, 国产算力, 大模型发展趋势, 大语言模型, 开源AI模型, 推理效率优化, 数学推理模型, 深度求索, 稀疏注意力, 长上下文处理

Deepseek V3.2,12月1号发布了。是不是又遥遥领先了呢?

大家好,欢迎收听老范讲故事的YouTube频道。

Deepseek V3.2的发布应该是12月1日。我们始终没有等来心心念念的Deepseek R2。在今年春节的时候,深度求索突然发布了Deepseek R1,算是扔下了一颗深水炸弹,把整个AI圈都震动了,甚至还造成了英伟达股价的闪崩——一段时间内闪崩吧。甚至老黄都跑出来喊,说:“Deepseek发布对我是利好,你们不要卖英伟达的股票。”大家就一直等着这个R1,既然这么厉害,咱们上R2。但是等了这么久,都没有等来R2。

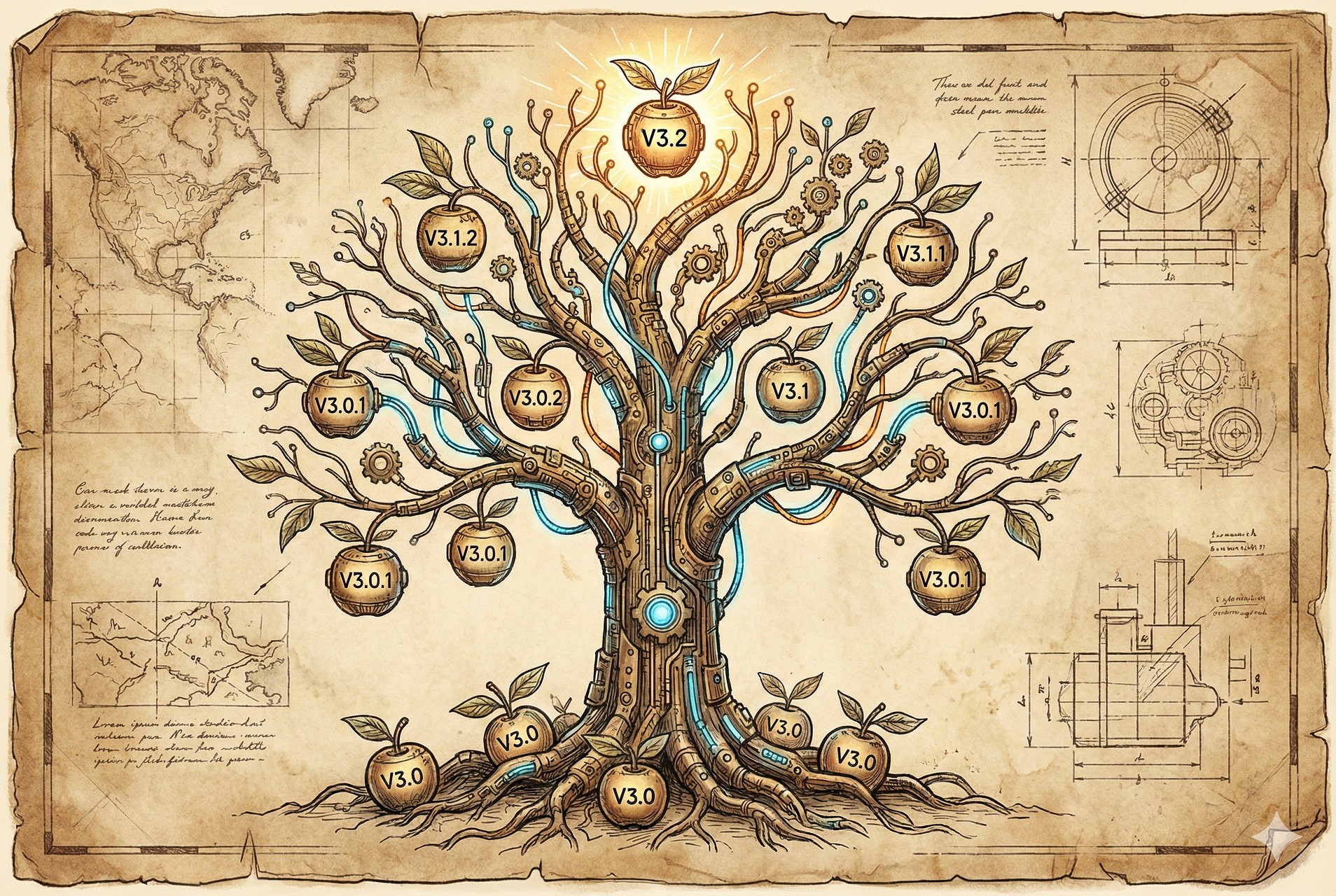

Deepseek V系列版本回顾

下面呢,我们来捋一下Deepseek V系列的版本到底是怎么样的一个发布过程。

- Deepseek V3 (去年12月26日发布): 这是非常非常重要的一个版本。实际上我们后面看到的所有版本,包括R1,都是在Deepseek V3的基础上进行微调、进行蒸馏、进行强化学习。今天发布的Deepseek V3.2,也依然是在这个版本的基础上做出来的。

- Deepseek V3-0324 (3月24日发布): 主要是在专项能力上做了一些增强,比如说编代码或者写文章。

- Deepseek V3.1 (8月21日发布): 主要是工程化和智能体方面做了增强。因为当时大家都要去做AI agent,而之前的版本在AI agent这一块都比较弱。

- Deepseek V3.1 Terminals (9月22日发布): 这个版本叫V3.1的终极版,实际上是对V3.1做了一些修复和精调,并告知这是V3.1的最终版本。

- V3.2 EXP (9月29日发布): 一个实验版本,在V3.1终极版的基础上加入了DSA技术。最主要的变化是降价,直接把API调用的价格砍了一半。

- Deepseek OCR (10月20日发布): 一个很小的模型(约6G),用于图片解释,效果很好。

- maths VR (11月27日发布): 专门做数学推理和数学证明的一个版本,在各种数学题测试中评分非常高。

- Deepseek V3.2 正式版 & V3.2 special 特别版 (12月1号发布): 本次发布的主角。

More

11 月 28

Luke FanAIGC AGI, AI创业公司, AI发展方向, AI安全, AI小镇做题家, AI情感判断, AI未来, AI模型, AI泡沫, AI科研, Daniel Gross, Ilya Sutskever, NVIDIA, OpenAI, OpenAI创始人, Safe Superintelligence, Sam Altman, Scaling law, Superintelligence, Transformer瓶颈, 价值函数, 大语言模型

伊利尔·苏斯克维的专访:他到底说了些什么?

大家好,欢迎收听老范讲故事的YouTube频道。

伊列尔·苏斯克维,很多人说:“这哥们是谁?”就是和马斯克、山姆·奥特曼一起创建OpenAI那哥们。在2023年11月份,对山姆·奥特曼进行逼宫以后,休假了很长时间,然后从OpenAI离职的。这一位算是OpenAI的创始人吧,他离职了以后呢,自己闷头去做研究,好长时间没有他的声音了,现在突然出来接受了一次专访。

引言:AI界的科学家与当下的迷茫

首先要注意,这哥们不是一个工程师,他是一个科学家。工程师跟科学家之间还是有很大差异的。使用确定的技术、加大投入、获得可预期的结果,这是工程师干的活;研究不确定的方向,这是科学家干的事情。所以,他是一位科学家。

现在很多人都在讨论AI是不是有泡沫。现在距离走通“最后一步”还有一点点小的差距。到底什么叫“最后一步”?就是AI真正的落地,真正的开始改变很多东西,开始挣钱。这一步现在还是有一点点差距的。但是呢,很多人也在否认AI泡沫的存在。AI虽然没有走通最后一步,但是AI真的带来很多失业。“钱我没挣着,但是我真的把人的工作干掉了。”现在是大家都比较迷茫的一个时间点。

原来那些应该默默无闻做研究的科学家,就携带了巨大的光环跑出来说话了。本来这些科学家说的话呢,应该是在很小的圈子里边流传,但是现在大家看看李飞飞、杨乐坤,包括今天咱们讲的伊利尔说的这些话,也成为了大众讨论的话题。

核心观点一:科学研究与工程研发的转化

“科研现在需要相互转化了”,这就是这一次伊利尔访谈的一个核心观点。你说,科研科研不是一回事吗?不是,科学跟研究是两回事,它是分为“科学研究”和“工程研发”,它是两个不同的概念。

科学研究呢,是在发现方向。发现了方向以后,就可以堆钱、堆算力、堆数据,在各种行业里边进行测试,这个呢都叫工程研发。就像前面他们研究了半天,到底哪个算法是可以把这个大模型做出来的,最后发现Transformer算法是可以搞定的,发现方向了。到发现Transformer方法有效之前,都是在做科学研究。在Transformer出来以后,大家说:“咱们堆钱吧!”玩这个scaling law,就是直接往里头去堆算力、堆数据、堆这些东西了,这就开始玩工程研发了。这个都是确定的东西,我们只管往里堆钱就完了。

工程研发呢,有一个不可避免的问题,就是你万一站到了一个小山头上,朝任何一个方向走都是下坡。工程研发的时候,他也是会寻找更高的一个山头往上爬,但是你爬到一个最高的山头的时候,你就没法往前走了,因为你不知道应该往哪个方向走了。如果有一个离你很近的山头,你还可以去尝试的跳一跳;如果下一个山峰离你非常遥远的话,这个工程研发是没有办法去跨越鸿沟的。那么在这个时候就应该重新走回来,做科学研究了,重新去尝试那些现在不确定的方向。这就是这一次伊利尔访谈的一个核心观点。

所有的科学家最大的能力是不是科学?其实不是这样。所有的科学家,特别是成功的科学家,他们最大的能力是筹措经费和资金。特别是现在这个时间点,任何一项科学研究都是需要海量资金去堆砌的。现在已经不能说科学家坐在家里头,闭门造车多少年,最后研究出一个神奇的东西出来,现在已经过了那个时间点了。

More

11 月 21

Luke FanAIGC, Meta的故事 Advanced Machine Intelligence, AI pioneer, AI research, AI Startup, AI strategy, AI商业化, AI教父, AI科学家, Alexander Wang, chief AI scientist, Facebook AI, FAIR, godfather of AI, JEPA, launch startup, Llama大模型, machine intelligence, Meta, Meta AI, Meta AI战略, PyTorch, world model, Yann LeCun, Yann LeCun leaves Meta, 世界模型, 人工智能, 具身智能, 图灵奖得主, 大语言模型, 扎克伯格, 李飞飞, 杨乐坤, 杨乐坤离职, 非生成式AI

杨乐坤出走Meta:一场关于战略、用人和未来的博弈

大家好,欢迎收听老范讲故事的YouTube频道。

这一天还是来了。前面我们已经猜测了很久,说杨立昆到底什么时候会离开,因为所有人都眼睁睁地看着Meta的AI战略转换方向。亚历山大·汪进入Meta,一个28岁的辍学生,在管理65岁的大学教授和图灵奖得主,这个事一定不能长久。而且前面还对杨立昆手下的FAIR部门进行了600人的裁员。

靴子落地:杨乐坤宣布离职

现在靴子终于落地了。2025年11月19日,当地时间13:20,杨立昆发了一个长文宣布离职了。在这个文章里边,他回顾了一下在Meta待了12年,感谢了小扎和一堆高管,然后准备要去做他的AMI。他这个AMI呢,叫做“高级机器智能”,说:“我在Meta期间就一直在干这件事,现在呢我准备出去了以后接着干。”而且新公司呢,Meta依然还有参与,具体的情况后续再公布。他呢,也终于可以不受Meta的限制,去研究自己的世界模型了。

杨立昆也要去做世界模型,跟李飞飞有些相近。最后咱们再说一下,他的世界模型跟李飞飞的世界模型到底有什么差别。

Meta呢,应该在这个里边还是给了钱的。你请这样的一位大神出去,而且大神在发文的时候还感谢了扎克伯格,那一定还是要给钱的。所以杨立昆未来的公司里头,Meta应该还是一位重要的股东。但是到底给了多少钱,占了多少股份,可能还要等未来Meta的官宣,现在应该公司还在注册过程中吧。

More

11 月 19

Luke FanAIGC, 马云和阿里的故事 AI, AI Assistant, AI产品设计, AI助手, AI行业分析, Alibaba, Alibaba Cloud, C-end, ChatGPT, C端应用, Ecosystem, Gemini, Generative AI, Large Language Models, LLM, Open Source, Qwen, Tech Giant, Tongyi Qianwen, 人工智能, 内部竞争, 创新困境, 千问APP, 大厂创新, 大语言模型, 夸克APP, 字节跳动, 山头主义, 开源模型, 来往与微信, 生成式AI, 电商生态, 百度, 科技巨头, 科技评论, 腾讯, 豆包, 通义千问, 阿里云, 阿里巴巴, 马云

千问APP:阿里的绝地反击,还是又一个“来往”?

千问APP大家都试过了吗?这是阿里的绝地反击,还是又来了一次“来往”一样的故事呢?大厂为什么总是在创新的时候,起个大早,赶个晚集呢?大家好,欢迎收听老范讲故事的YouTube频道。

千问APP的短暂狂欢与第一印象

千问APP带来了一个短暂的狂欢。阿里这个模型这么强的公司,终于也要出一款APP,C端的APP要去对标ChatGPT了。阿里的股价短暂上涨,然后被一个很奇怪的小作文,据说是有人看了白宫里边泄密的文件,说阿里为中国军方提供服务,马上要接受制裁了,所以阿里股价又跌回去了。

这一次的短暂狂欢呢,来自于一个很拙劣的吹风方式,说阿里在搞一个秘密项目,据说呢是集团高层定的战略,大家都在一起封闭开发,具体在干什么不知道。但是呢,突然发现食堂里边吃大量的粤菜,食堂的师傅被要求做粤菜,这一定是由广东过来的团队在做项目。当时就在吹风说在做千问APP。那么为什么是广东团队在做?待会咱们后边再讲。

产品上线呢,也确实引发了关注。第一天服务器短暂崩了一次。现在新产品上线,如果连服务器都不崩一次的话,好像流程没有走完,所以千问上线的时候也短暂的崩了一下。用起来的感觉呢,一言难尽。我确实把它下载下来用了一下,这个东西说是对标ChatGPT,却是比豆包更“豆包”的一个产品。

More

10 月 29

Luke FanAIGC AI安全, Anthropic, GEO, Llama 3, LLM脑腐, 人工智能变傻, 低质量数据, 儿童教育, 千问模型, 反社会人格, 可信人工智能, 垃圾数据训练, 大模型催眠, 大模型脑腐, 大语言模型, 思维链, 持续预训练, 指令微调, 推理能力下降, 数据投毒, 数据污染, 数据配料表, 模型人格, 模型退化, 注意力分散, 生成结果优化, 短视频危害, 训练数据安全, 逻辑思维

大家好,欢迎收听老范讲故事的YouTube频道。

德州华人学者的新发现:大模型也能得“脑腐”

德州的一群从小被妈妈们说“手机看多了会瞎”的华人发了一篇文章。德州农工大学、德州大学奥斯汀分校、普渡大学,这三个学校有8位作者联合发了一篇文章。从名字上看,有一个人是非拼音名字的,看着像个老外,其他所有人的名字,特别是一作和通讯作者的名字,都是拼音的名字,应该是华人。

那这个文章叫什么呢?叫《LLMS can get brain rot》,它的意思呢,叫做大语言模型也能得“脑腐”。就像是咱们新冠疫情以后经常说,脑子上好像总有一层雾,感觉注意力不集中,总是觉得想事情想不清楚,经常忘事情。现在说,大语言模型也可以干这件事。

首先呢,有一个简单的结论,就是给大语言模型喂垃圾数据,大语言模型就像得了脑腐一样变傻了。即使再用好的数据进行修复,中间喂过垃圾数据了,我后边一直喂好数据,可以改善,但是呢,永远无法达到原来的状态。也就是说,喂垃圾数据的这种伤害是永远不可能完全修复的。这是一个很悲观的结论。

More

9 月 10

Luke FanAIGC AI与教育, AI伦理, AI准确性, AI安全, AI幻觉, AI推理, AI生成内容, AI训练方法, ChatGPT, Github Copilot, GPT-4, GPT-5, OpenAI, OpenAI论文, 事实准确性, 人机交互, 分支聊天, 多模型校验, 大语言模型, 李飞飞, 模型幻觉原因, 训练数据, 评估体系, 降低AI幻觉, 预算强制法

GPT5降低幻觉的秘密被OpenAI给公开了。现在看来,训练AI真的是越来越像训练小孩子了。

大家好,欢迎收听老范讲故事的YouTube频道。

九月五号真的是一个神奇的日子,非常多的模型都在九月五号被发布出来。OpenAI在这一天也发表了一篇论文,这个论文叫做《为什么语言模型会产生幻觉》。

大语言模型从进入我们的日常生活那一天开始,我们就发现了,这个东西最擅长干的事情是什么?叫“一本正经的胡说八道”。

现在OpenAI公布了,说产生幻觉有两个主要原因。

第一个原因叫做“错误的评估体系”。什么意思呢?就是我们现在去考试了,做对了1分,做错了0分,不做也是0分。其实我们所参加的绝大部分的考试,都是这样去设计的,甭管你是考英语、考数学,都是这样设计。像考数学这种,他还有步骤分,哪怕最后你的结果没有,或者结果是错误的,你只要前面的步骤写对了几步,他都是给你分的。

More

9 月 01

Luke FanAIGC AI, AI与大脑, AI伦理, AI写作, AI协作, AI味, AI工具使用, AI影响, AI的利与弊, ChatGPT, MIT研究, 人机共生, 人机关系, 人类思维, 大语言模型, 思考方式, 批判性思维, 文章归属感, 未来科技, 独立思考, 认知, 认知科学, 认知负债, 语言, 语言同质化

AI用多了人会变笨吗?

大家好,欢迎收听老范讲故事的YouTube频道。今天咱们来讲一讲MIT最新的一个研究:用AI会让人变笨。

文章的标题是“你的大脑与ChatGPT:使用人工智能助手完成论文写作任务时的认知负债积累”。说白了,就是你用ChatGPT用得越多,你的认知负债也就越多。这个文章是MIT的媒体实验室发出来的,MIT这个媒体实验室还是非常著名的一个实验室。这篇文章呢,是2025年6月10日在Arxiv上的预印本的论文。现在有一个新的发论文的地方叫Arxiv,很多没有经过编辑审核、没有杂志社确认的这些论文就都可以放在这了。数学、计算机等等这些学科的大量论文都是会先放在这里,大家可以先开始看起来,因为科技实在是发展得太快了。有一些呢,修改过以后会重新发到杂志社上去,放到这上面并不算抢发。杂志社发的时候还会提出修改意见,你改完了以后会去更新Arxiv上的论文。

这个实验做了什么呢?18-39岁的54个人分成三组:纯脑力组、使用谷歌搜索引擎组和使用ChatGPT组。这三组呢,在20分钟之内写一篇SAT水平的考试作文。SAT呢,一般要求是开放式的、哲学或社会性讨论的这种问题,比如艺术的力量、成就的意义等等这样的题目。所以相对来说比较文科,比较开放的一个题目。

More

8 月 13

Luke FanAIGC AIGC, AI伦理, AI女友, AI应用, AI换脸, AI生成内容, AI绘画, AI聊天, AI色情, AI视频, ChatGPT, ComfyUI, Deepfake, Grok, Hugging Face, LLM, Lora模型, MidJourney, NSFW, stable diffusion, 中国刑法, 主观意愿, 人工智能, 传播淫秽物品牟利罪, 传播淫秽物品罪, 儿童色情, 刑事案件, 判例分析, 名誉权侵害, 大语言模型, 开源模型, 律师解读, 捏脸, 新加坡案例, 无罪辩护, 法律与科技, 法律案例, 法律盲区, 法律红线, 法律风险, 洁身自好, 牟利, 美国法律, 虚拟女友, 虚拟色情, 认罪认罚, 证据认定, 越狱提示词, 通义万象, 通义千问, 道德底线, 郭庆子律师, 量刑标准, 韩国判例

新时代和AI女友聊骚,有可能会触犯传播淫秽物品罪,这到底是一个什么样奇葩的故事?

大家好,欢迎收听老范讲故事的YouTube频道。

今天我一个朋友,向我推荐了一个有趣的案例。他是在视频号上,这个账号的名字呢,叫做“武汉刑事律师郭庆子”,是一个黄标认证的律师。这位律师呢,经常会把自己接听有刑事诉讼需求的听众的一些电话的过程录下来,再进行剪辑。因为这种东西,我估计不太好直播,总是要剪辑一下。一方面呢,是一些太敏感的信息就可以去掉;另外一方面呢,剪辑了以后呢,也会更有吸引力一些。

这个里头呢,有一位听众来电了,说使用AI应用,这个AI应用里头就提供一些AI女友,你可以跟她们去聊天。他通过自己捏脸,塑造了一些AI女友,大概塑造了9个,起的名字呢,都是比较有诱惑力的名字吧。这些AI女友,除了它定义的名字和捏脸之外呢,估计有可能会可以定义一些系统提示词。但是呢,这个视频很短,并没有去详细说具体是哪一个AI应用,或者说他到底在里边定制了哪些东西。总之呢,他定制了9个AI女友。

More

8 月 12

Luke FanAIGC AGI, AI人格, AI创业, AI生态, AI竞争, Anthropic Claude, API价格, ARC-AGI测试, Gemini 2.5 Pro, GPT-5, Grok-4, Meta, OpenAI, Plus用户, Pro用户, Sam Altman, Thinking模式, XAI, 上下文窗口, 中国AI公司, 人工智能, 代码生成, 价格战, 免费用户, 划时代革命, 各安天命, 哀鸿一片, 商业模式, 多模态, 大语言模型, 开发者, 微软, 抄后路, 投名状, 挤牙膏, 用户体验, 科技评论, 统一模型, 老范讲故事, 行业分析, 谷歌, 跑分对比, 阶级固化, 降低幻觉, 马斯克

大家好,

欢迎收听老范讲故事的YouTube频道。

今天咱们来讲一讲GPT-5发布了,到底是又一次划时代的革命,还是开始挤牙膏了呢?

8月8号凌晨开的发布会,我呢看了一眼就去睡觉了,实在是没有功夫把它都看完。北京时间凌晨1点开始发,我今天看了一下回放,大概是一个小时十几分钟吧,但是我并没有特别耐心地把它们都看完。

GPT-5到底有什么不一样的呢?

首先,这一次的发布会跟OpenAI以前的发布会,有一些巨大的差异。第一点大家有没有注意到,就是这次发布以后呢,没有出现服务器拥挤宕机的情况。以前甭管是Sora呀,还是GPT-4o这些产品发布的时候,紧随而来的都是OpenAI的服务器拥堵宕机。这次没有,第一时间就可用,免费版也可以使用,速度还挺快的。我自己反而感觉速度还可以,应该呢是进行了一些实时的算力分配,简单的问题就没必要消耗那么多的算力。原来呢,大家都是要尽可能用最大的模型,你哪怕问一个“你好,今天天气不错”,他也得把那个最大的模型跑起来。现在的话应该就不需要干这个事了,他发现你去问“你好,你是谁,你到底是哪个版本”的时候,他可能做一些很简单的回复,消耗的算力就比较小。这是第一个比较大的差异。

More

7 月 07

Luke FanAIGC, 华为很厉害 AI伦理, AI大模型, AI抄袭, Apache 2.0, GitHub事件, honest AGI, Hugging Face, Llama 3.1, LLaMA-fingerprint, LLM, Meta, OpenAI, POWERED by盘古, PyTorch, 人工智能, 企业公关危机, 华为, 品牌形象, 增量训练, 大模型套壳, 大模型抄袭, 大模型指纹算法, 大语言模型, 字节跳动, 开源, 开源争议, 开源协议, 开源文化, 归属声明, 抄袭指控, 昇腾芯片, 模型相似度, 欧盟禁用条款, 民族主义情绪, 注意力机制, 混合专家模型(MOE), 版权声明, 瓜田李下, 盘古大模型, 盘古开源协议, 科技伦理, 科技公司纠纷, 科技评论, 老范讲故事, 自主研发, 舆论战, 英伟达芯片, 观点分析, 许可证, 豆包, 辟谣, 通义千问, 遥遥领先, 闭源, 阿里巴巴

华为开源了盘古大模型,被指抄袭。华为到底冤不冤呢?

大家好,欢迎收听老范讲故事的YouTube频道。华为开源了他的盘古大模型,它的模型呢,反正依然是山海经风格的起名。原来呢,没有开源,都是说我们内部开发内部使用,或者说我们专门供政府和大企业来使用。但是现在发现开源这条路不错,那我也开源吧。结果开源了以后就出事了。

它是6月30号在GitHub上就直接开源了,号称呢是在升腾芯片上训练出来的大模型。以前呢,我们的大模型大多是在英伟达芯片上训练,但是呢可以在升腾的芯片上去做推理。现在说,我直接在升腾芯片上做训练,也算是一种小的突破吧。

他呢,其实发了两个模型:一个是72B的MOE的模型,就是混合专家模型;然后呢,有一个70B的稠密模型。做呢做完了,但是准备开源还需要准备一段时间。开源这件事,不是说你做完了,把它扔出来就完了,还是有很大的工作量需要干的。比如说你要去写开源手册、许可证,这个还不是那么容易,还在做。

More

Older Entries

RSS

RSS